1.项目

Dify 是一个开源的 LLM(大型语言模型)应用开发平台,旨在帮助开发者快速构建和部署基于大型语言模型的应用程序。它提供了从模型训练、数据处理到应用部署的全流程支持,降低了开发门槛,让开发者能够更高效地创建智能应用。

1.1项目介绍

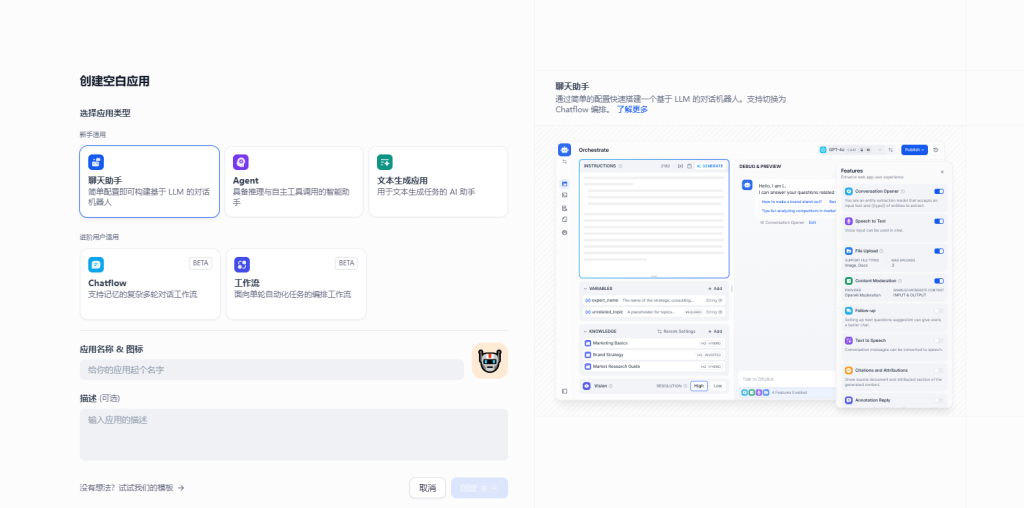

- 可视化开发:

- 提供拖拽式界面,简化开发流程,无需编写复杂代码。

- 支持快速构建 LLM 应用,如聊天机器人、内容生成工具等。

- 多模型支持:

- 兼容多种主流 LLM,如 OpenAI 的 GPT 系列、Hugging Face 的模型等。

- 支持自定义模型接入,灵活适配不同需求。

- 数据管理:

- 提供数据集管理功能,便于开发者上传、标注和管理训练数据。

- 支持数据预处理和优化,提升模型性能。

- 灵活部署:

- 支持本地、云端或混合部署,满足不同场景需求。

- 提供 API 接口,方便与其他系统集成。

- 开源与社区驱动:

- 完全开源,开发者可以自由定制和扩展功能。

- 社区活跃,持续更新和改进。

适用场景:

- 智能客服:快速构建基于 LLM 的对话系统。

- 内容生成:自动生成文章、文案、代码等。

- 数据分析:通过自然语言处理数据并生成报告。

- 个性化推荐:基于用户行为生成个性化内容推荐。

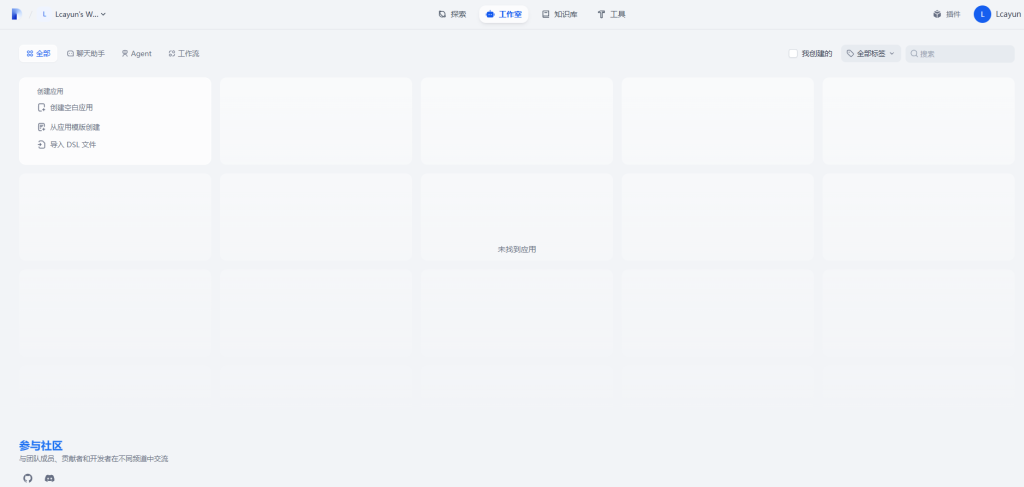

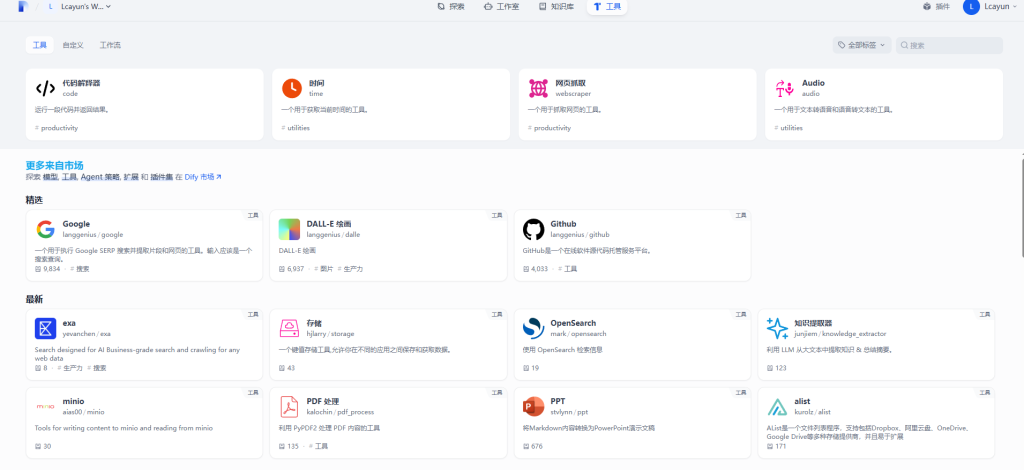

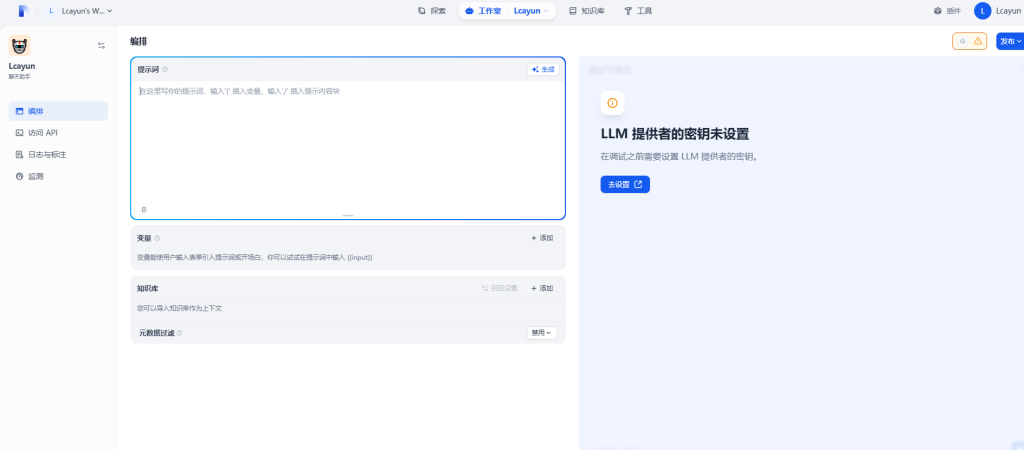

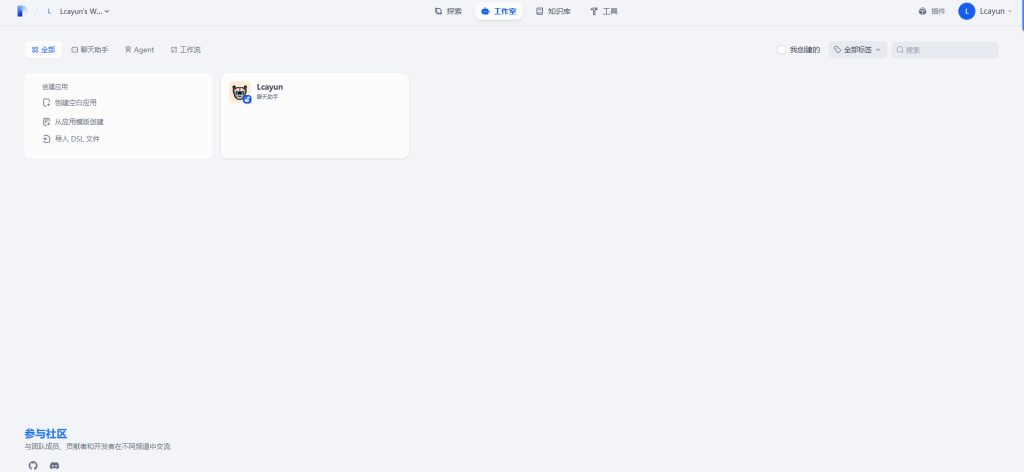

1.2项目展示

2.相关地址

3.搭建环境

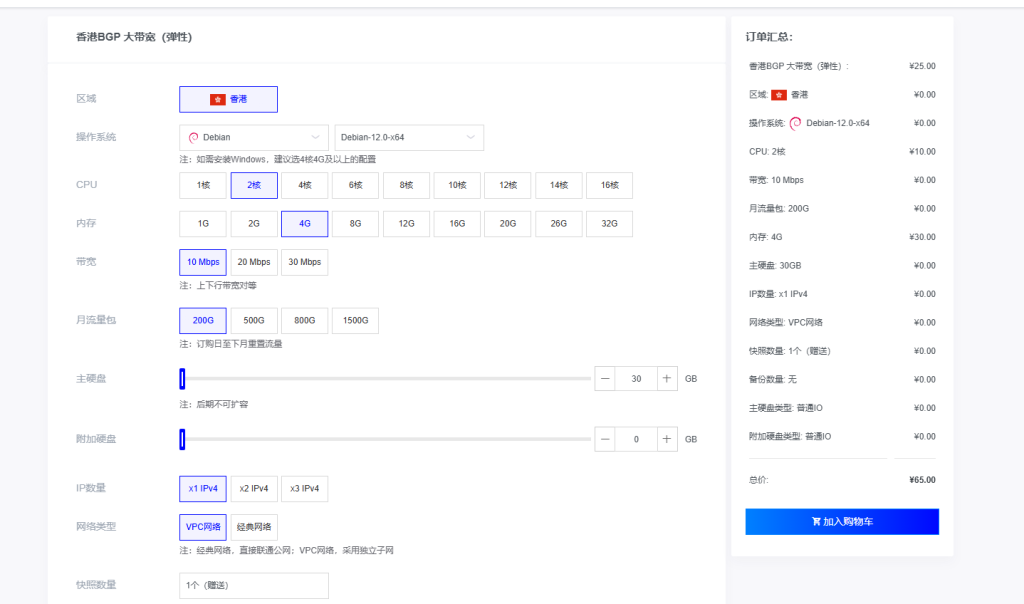

- 服务器:这里为了方便搭建项目使用的是莱卡云的境外香港云服务器。(如果是国内用户连接建议使用国内的服务器(需备案域名)延迟会更低)

- 莱卡云服务器促销活动性价比会更高。查看官网购买链接:https://www.lcayun.com

- 资源配置:2核4G 30G硬盘

官方建议服务器是2核4G以上,由于国内服务器访问海外源较慢,这边为了方便演示直接使用海外服务器搭建。 - 服务器系统:Debian-11

- 【必需】安装Docker:安装好 Docker、Docker-compose

- 【非必需】域名一枚,可用于解析到服务器上使用域名访问

4.搭建视频

哔哩哔哩:https://www.bilibili.com/video/BV1s7XaYKEAg/

5.搭建方式

5.1 安装docker和docker-compose

安装教程:服务器上安装docker和docker-compose教程

5.2 安装Dify

克隆 Dify 代码仓库,克隆 Dify 源代码至本地环境。

git clone https://github.com/langgenius/dify.git5.3 启动 Dify

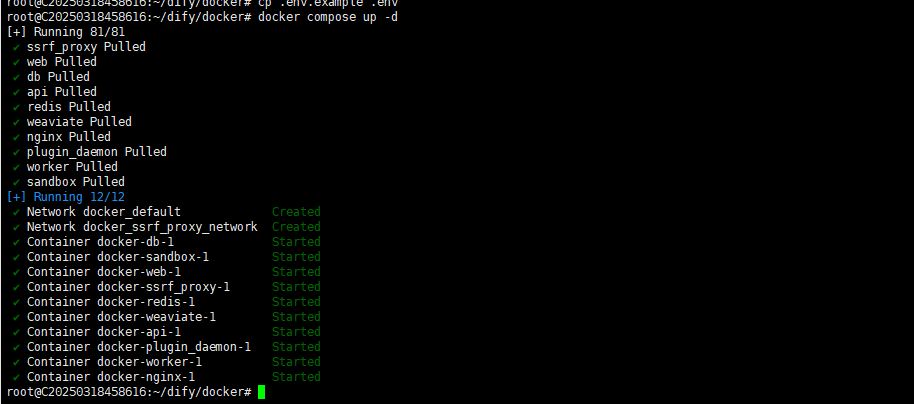

进入 Dify 源代码的 Docker 目录

cd dify/docker复制环境配置文件

cp .env.example .env启动 Docker 容器

docker compose up -d运行命令后,你应该会看到类似以下的输出,显示所有容器的状态和端口映射:

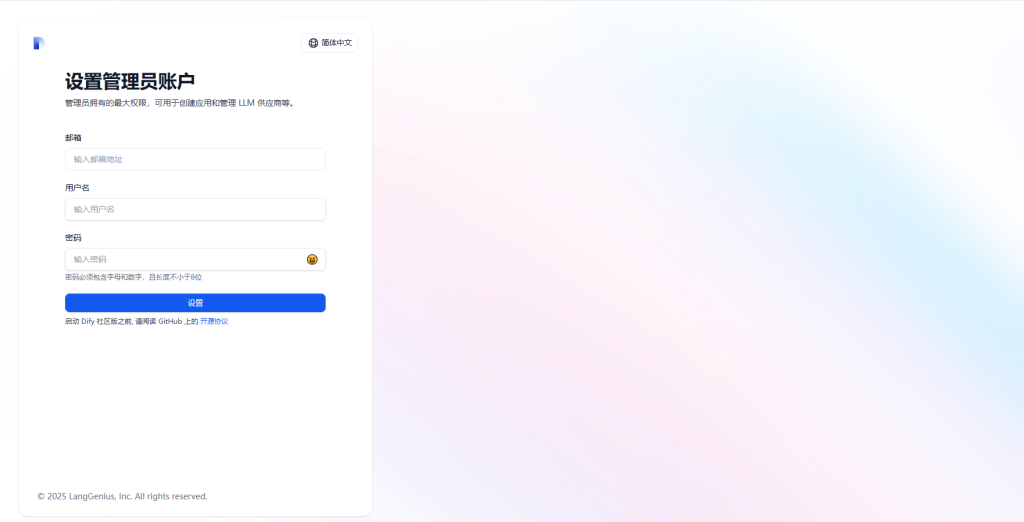

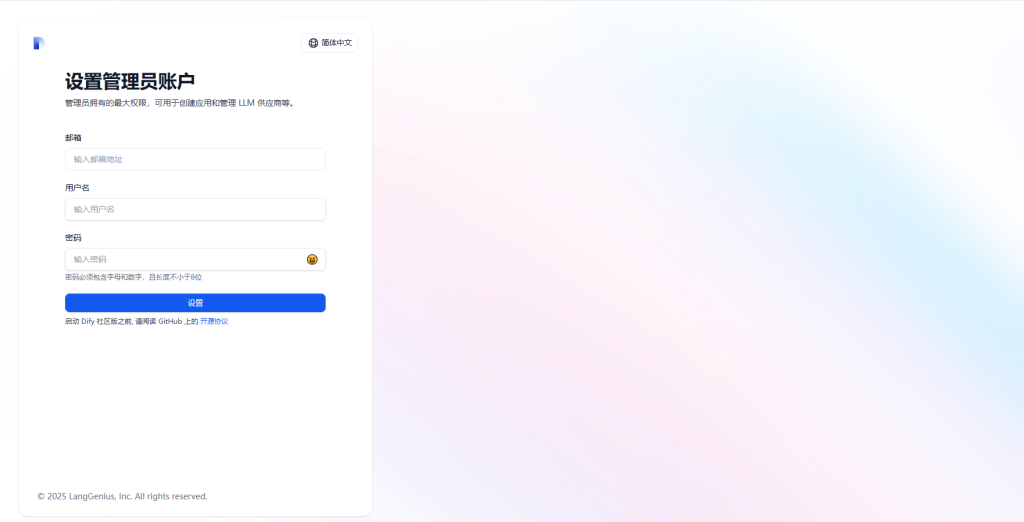

运行后,您可以通过浏览器通过 http://localhost/install 访问 Dify 仪表板并开始初始化过程。

localhost替换为您的服务器IP地址

然后设置好管理账户跟密码即可登录

后续,可以通过配置域名关联该服务器外网IP,通过域名访问此Dify服务。

6.结尾

通过以上步骤,已经成功搭建出了Dify平台,剩下的可以参考Dify文档操作添加API等操作,可以打造属于自己的AI系统应用